BTC/USD-2.22%

BTC/USD-2.22% ETH/USD-3.26%

ETH/USD-3.26% LTC/USD-2.4%

LTC/USD-2.4% ADA/USD-3.2%

ADA/USD-3.2% SOL/USD-3.14%

SOL/USD-3.14% XRP/USD-2.16%

XRP/USD-2.16%Los modelos de aprendizaje automático tienden a sobreajustarse cuando se usan con conjuntos de datos de blockchain. ¿Qué es el overfitting y cómo solucionarlo?

A primera vista, la idea de usar el aprendizaje automático para analizar conjuntos de datos de blockchain suena muy atractiva, pero es un camino desafiante. Entre estos desafíos, la falta de conjuntos de datos etiquetados sigue siendo el mayor desafío a superar al aplicar métodos de aprendizaje automático a conjuntos de datos de blockchain. Estas limitaciones hacen que muchos modelos de aprendizaje automático operen con muestras de datos muy pequeñas para entrenar y optimizar en exceso esos modelos que causan el fenómeno de sobreajuste. Hoy, quiero profundizar en el desafío del sobreajuste en el análisis de blockchain y sugerir algunas soluciones.

El sobreajuste se considera uno de los mayores desafíos en las aplicaciones modernas de aprendizaje profundo. Conceptualmente, el sobreajuste ocurre cuando un modelo genera hipótesis que se adaptan demasiado bien a las de un conjunto de datos en particular para adaptarse a nuevos conjuntos de datos. Una analogía útil para comprender el sobreajuste es pensar en él como una ilusión en el modelo. Esencialmente, el modelo alucina/sobreajusta cuando infiere suposiciones incorrectas del conjunto de datos. Se ha escrito mucho sobre el sobreajuste desde los primeros días del aprendizaje automático, por lo que no creo que haya una forma inteligente de explicarlo. Para los conjuntos de datos de blockchain, el sobreajuste es un resultado directo de la falta de datos etiquetados.

Apertura de acciones A: el índice Blockchain 50 de la bolsa de valores de Shenzhen cayó un 0,49%: Jinse Financial News, se abrieron las acciones A, el índice compuesto de Shanghái cerró en 3445,97 puntos, un 0,14% menos en la apertura, el índice de componentes de Shenzhen cerró en 13811,59 puntos, menos 0,01% en la apertura, distrito de la bolsa de valores de Shenzhen El índice Blockchain 50 estaba en 3528,1 puntos, un 0,49% menos en la apertura. El sector de la cadena de bloques abrió con una caída del 0,06 % y el sector de la moneda digital abrió con un 0,29 %. [2021/4/12 20:09:37]

Las cadenas de bloques son grandes estructuras de datos semianónimas en las que todo se representa mediante un conjunto común de construcciones, como transacciones, direcciones y bloques. Desde este punto de vista, hay información mínima para probar el registro de blockchain. ¿Es una transacción de transferencia o de pago? ¿Es esta la dirección de una billetera de inversionista personal o una billetera fría de intercambio? Estos calificadores son cruciales para los modelos de aprendizaje automático.

Imagine que estamos creando un modelo para detectar direcciones de intercambio en un conjunto de cadenas de bloques. Este proceso requiere que entrenemos el modelo utilizando un conjunto de datos existente de direcciones de blockchain, que todos sabemos que no es muy común. Si usamos un pequeño conjunto de datos de EtherScan u otras fuentes, el modelo podría sobreajustarse y hacer clasificaciones incorrectas.

Blockchain Association contrata al exjefe de relaciones gubernamentales de Ripple como nuevo jefe de relaciones gubernamentales: el grupo de defensa de las criptomonedas y blockchain Blockchain Association (Blockchain Association) ha contratado a Ron Hammond como su nuevo jefe de relaciones gubernamentales, se informó el 10 de febrero. Se informa que Ron Hammond es el ex gerente de relaciones gubernamentales de Ripple. (Cointelegraph) [2021/2/10 19:22:29]

Uno de los aspectos que hace que el sobreajuste sea tan desafiante es que es difícil generalizar a través de diferentes técnicas de aprendizaje profundo. Las redes neuronales convolucionales tienden a desarrollar patrones de sobreajuste que son diferentes de los observados para las redes neuronales recurrentes que los modelos generativos, y este patrón puede extrapolarse a cualquier tipo de modelo de aprendizaje profundo. Irónicamente, la tendencia al sobreajuste aumenta linealmente con el poder computacional de los modelos de aprendizaje profundo. Dado que los agentes de aprendizaje profundo pueden generar hipótesis complejas casi gratis, la posibilidad de sobreajuste aumenta.

El sobreajuste es un desafío constante en los modelos de aprendizaje automático, pero cuando se trabaja con conjuntos de datos de blockchain, es casi un hecho. La respuesta obvia al sobreajuste es usar un conjunto de datos de entrenamiento más grande, pero esta no siempre es una opción. En IntoTheBlock, a menudo nos enfrentamos al desafío del sobreajuste y confiamos en una serie de métodos básicos para resolver el problema.

Dinámica | El Banco Agrícola de China lanzó un sistema de puntos digitales para clientes de cadena de bloques, con más de 13 millones de participación de clientes: según China Information Network, el Banco Agrícola de China continúa promoviendo la construcción del sistema de puntos del banco de palmeras (denominado "Xiaodou "). "Xiaodou" es un sistema de crédito digital para clientes de banca móvil creado por el Banco Agrícola de China basado en la tecnología blockchain, que utiliza varios derechos e intereses para alentar a los clientes a experimentar más funciones y servicios clave de la banca móvil. Según las estadísticas, "Xiaodou Paradise" ha acumulado más de 13 millones de clientes participantes desde su lanzamiento hace un año. [2018/8/28]

Tres estrategias simples para combatir el sobreajuste en conjuntos de datos de blockchain

La primera regla general contra el sobreajuste es reconocerlo. Si bien no existe una bala de plata para evitar el sobreajuste, la experiencia práctica ha demostrado que algunas reglas simples, casi de sentido común, pueden ayudar a prevenir este fenómeno en las aplicaciones de aprendizaje profundo. Para evitar el sobreajuste, se han publicado decenas de mejores prácticas, que contienen tres conceptos básicos.

Proporción de datos/supuestos

El sobreajuste generalmente ocurre cuando un modelo genera demasiadas hipótesis sin los datos correspondientes para probarlas. Por lo tanto, las aplicaciones de aprendizaje profundo deben tratar de mantener una proporción adecuada entre el conjunto de datos de prueba y la hipótesis que debe evaluarse. Sin embargo, esto no siempre es una opción.

La Oficina Reguladora de Seguros de Shanghái construye la primera plataforma de reaseguro de cadena de bloques en China: China Economic Herald publicó hoy un artículo que indica que en el negocio diario de los seguros, aunque las transacciones no son tan frecuentes como las de los bancos y los valores, la dependencia y la demanda de datos creíbles esta incrementando. La Oficina Reguladora de Seguros de Shanghái creó la primera plataforma de reaseguro blockchain en China. El propósito de la plataforma experimental es verificar la viabilidad de aplicar la tecnología blockchain en la práctica del reaseguro, y utilizar la tecnología blockchain para procesar transacciones de reaseguro entre empresas tiene ventajas únicas. La plataforma de transacciones de reaseguro desarrollada en base a la tecnología blockchain no solo puede completar el proceso de transacción, sino también integrarse en un ecosistema de transacciones multicadena unificado, lo que conduce a mejorar la eficiencia y precisión del procesamiento de facturas de reaseguro. [2018/3/28]

Hay muchos algoritmos de aprendizaje profundo (como el aprendizaje inductivo) que se basan en la generación continua de hipótesis nuevas, a veces más complejas. En estos casos, existen algunas técnicas estadísticas que pueden ayudar a estimar el número de hipótesis correctas para optimizar las posibilidades de encontrar una que se acerque a la correcta. Aunque este método no puede proporcionar una respuesta exacta, puede ayudar a mantener una relación estadísticamente equilibrada entre el número de hipótesis y la composición del conjunto de datos. El profesor de Harvard Leslie Valiant explica brillantemente este concepto en su libro "Probably Right".

Bubi CTO Wang Jing: La tecnología Blockchain se puede combinar orgánicamente con la financiación de la cadena de suministro: Recientemente, Bubi CTO Wang Jing dijo: "La financiación de la cadena de suministro se enfrentará a un escenario en el que los activos requieren una colaboración interinstitucional, lo que implica la división y circulación de los derechos de los acreedores, si la refactorización es para transferir activos financieros en bazares financieros o intercambios de oro, entonces los comerciantes enfrentarán el problema de confirmar la autenticidad o la singularidad de los reclamos.Por ejemplo, el número en la tecnología blockchain Los activos, como Bitcoin, pueden establecer un llamado libro mayor de la red entre varias instituciones, y no importa cómo se transfieran o dividan sus reclamos, se puede garantizar la unicidad de la propiedad ". [2018/3/21]

La relación datos/hipótesis es muy evidente cuando se realiza un análisis de blockchain. Supongamos que estamos construyendo un algoritmo predictivo basado en un año de transacciones de blockchain. Debido a que no estábamos seguros de qué modelo de aprendizaje automático probar, utilizamos un enfoque de búsqueda de arquitectura neuronal (NAS) que probó cientos de modelos contra un conjunto de datos de blockchain. Suponiendo que el conjunto de datos contiene solo un año de transacciones, el enfoque NAS puede producir un modelo que se ajuste perfectamente al conjunto de datos de entrenamiento.

Admite suposiciones simples

Una idea conceptualmente trivial pero técnicamente difícil para evitar que los modelos de aprendizaje profundo se ajusten en exceso es generar continuamente hipótesis más simples. ¡seguramente! Lo simple siempre es mejor, ¿no es así? Pero, ¿cuál es una suposición más simple en el contexto de los algoritmos de aprendizaje profundo? Si necesitamos reducir esto a un factor cuantitativo, diría que la cantidad de atributos en una hipótesis de aprendizaje profundo es directamente proporcional a su complejidad.

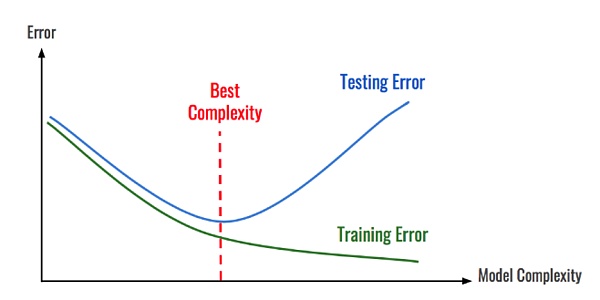

Las hipótesis simples suelen ser más fáciles de evaluar que otras hipótesis con fuertes propiedades computacionales y cognitivas. Por lo tanto, los modelos más simples generalmente son menos propensos al sobreajuste que los modelos complejos. Ahora, la siguiente pieza obvia del rompecabezas es descubrir cómo generar hipótesis más simples en modelos de aprendizaje profundo. Una técnica menos obvia es adjuntar algún tipo de penalización al algoritmo en función de la complejidad estimada. El mecanismo tiende a favorecer suposiciones más simples y aproximadamente precisas sobre suposiciones más complejas (ya veces más precisas) que pueden fallar cuando se dispone de nuevos conjuntos de datos.

Para explicar esta idea en el contexto del análisis de la cadena de bloques, imaginemos que estamos construyendo un modelo para clasificar las transacciones de pago en una cadena de bloques. El modelo utiliza una red neuronal profunda compleja que genera 1000 características para realizar la clasificación. Si se aplica a una cadena de bloques más pequeña como Dash o Litecoin, lo más probable es que el modelo se sobreajuste.

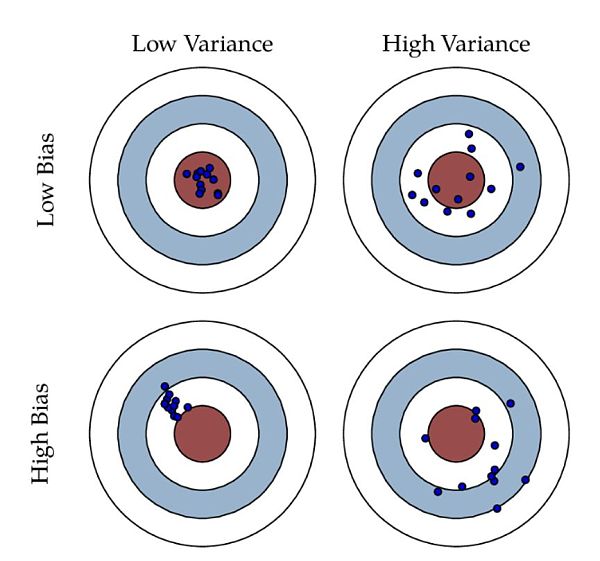

Balance de sesgo/varianza

El sesgo y la varianza son dos estimadores clave en los modelos de aprendizaje profundo. Conceptualmente, el sesgo es la diferencia entre la predicción promedio del modelo y el valor correcto que estamos tratando de predecir. Un modelo con alto sesgo presta poca atención a los datos de entrenamiento, lo que simplifica el modelo. Siempre da como resultado una alta tasa de error tanto en los datos de entrenamiento como de prueba. Alternativamente, la varianza se refiere a la variabilidad de las predicciones del modelo para un punto de datos dado o un valor que nos informa sobre la distribución de los datos. Un modelo con una varianza alta pone mucha atención en los datos de entrenamiento y no logra generalizar a datos que nunca antes había visto. Como resultado, dichos modelos funcionan bien con los datos de entrenamiento, pero tienen altas tasas de error con los datos de prueba.

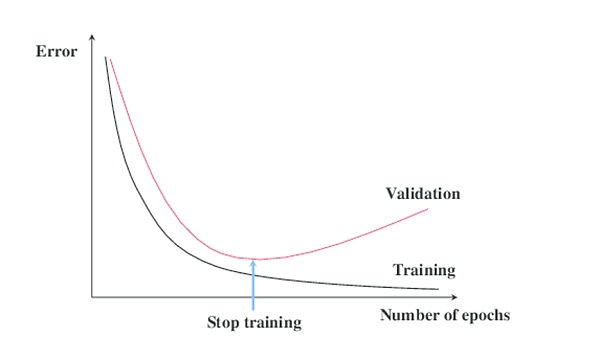

¿Cómo se relacionan el sesgo y la varianza con el sobreajuste? En términos súper simples, el arte de la generalización se puede generalizar reduciendo el sesgo de un modelo sin aumentar su varianza. Una buena práctica en el aprendizaje profundo es modelarlo para comparar periódicamente las hipótesis resultantes con un conjunto de datos de prueba y evaluar los resultados. Si la hipótesis continúa arrojando el mismo error, tenemos un gran problema de sesgo y necesitamos ajustar o reemplazar el algoritmo. Por el contrario, si no hay un patrón claro de errores, el problema es una discrepancia y necesitamos más datos.

En resumen

• Cualquier modelo de baja complejidad: propenso a fallar debido al alto sesgo y la baja varianza.

• Cualquier modelo de alta complejidad (red neuronal profunda): propenso al sobreajuste debido al bajo sesgo y la alta varianza.

En el contexto del análisis de la cadena de bloques, la fricción entre la variación y el sesgo está en todas partes. Volvamos a nuestro algoritmo, que intenta predecir el precio utilizando muchos factores de blockchain. Si usáramos métodos de regresión lineal simple, el modelo podría no ser apropiado. Sin embargo, si usamos una red neuronal ultracompleja con un conjunto de datos pequeño, el modelo puede sobreajustarse.

El uso del aprendizaje automático para analizar datos de blockchain es un espacio incipiente. Como resultado, la mayoría de los modelos sufren los desafíos tradicionales en las aplicaciones de aprendizaje automático. Fundamentalmente, el sobreajuste es uno de los desafíos omnipresentes en el análisis de cadenas de bloques debido a la falta de datos etiquetados y modelos bien entrenados

Tags:

Desde el nacimiento de Bitcoin en 2008, en poco más de 10 años, la moneda digital ha penetrado rápidamente en la comunicación diaria de las personas.En junio de 2019.

2019 ha sido un año extraordinario para blockchain y las criptomonedas. Echemos un vistazo a algunas de las posibilidades del ecosistema blockchain en 2020.

El Foro Económico Mundial (WEF) ha creado la primera organización global dedicada a diseñar un marco para la gobernanza transnacional de las monedas digitales. Como informó Cointelegraph.

Los modelos de aprendizaje automático tienden a sobreajustarse cuando se usan con conjuntos de datos de blockchain. ¿Qué es el overfitting y cómo solucionarlo?A primera vista.

Bitmain ha tenido mala suerte en el pasado, y después de la lucha interna, se rumoreaba que estaba involucrado en la estafa de BitClub.Recientemente.

En la era actual, las micro, pequeñas y medianas empresas desempeñan un papel insustituible en el aumento del empleo, la promoción del crecimiento económico y la innovación tecnológica. Sin embargo.

Nota del editor: este artículo son las diapositivas del director técnico de iden3, Jordi Baylina.